Qzone

Qzone

微博

微博

微信

微信

历时三年自主研发,基于自研架构的元核云青鸾分布式存储系统V2.0正式发布。不同于市场现有的基于开源架构二次开发的存储产品,青鸾存储架构由元核云独创研发,真正做到百分百技术自研、自主可控,更加贴合国产芯片,解决国产化存储落地最后一公里难题,实现全国产高性能存储“零”突破。此版本的发布也标志着元核云自主可控分布式存储架构进入新的里程碑。

青鸾(英文名:YESFS)是元核云基于国产化芯片平台设计研发的一款高性能分布式存储系统,2.0版本的产品性能在国产化申威平台实现了飞跃性的提升,采用了更适合申威多核架构的服务端线程模型设计,与申威平台特性高度贴合。同时,在产品设计之初就充分考虑了芯片市场的多样性,兼容X86平台,具备完善的产品生态。

青鸾能够充分释放国产芯片的全部能力,具有兼容对象、块、文件存储的全部接口支持,满足所有标准存储系统需求的业务场景,多种创新设计,突破国产存储性能瓶颈,全面超越传统存储,以高性能和高可用稳定支撑上层业务的数据需求。

传统存储架构在国产芯片的弊端凸显

目前,在软件定义分布式存储领域,CEPH架构和类CEPH架构占据主流地位,其核心思想是以统一的存储层,支持多种协议层扩展,其中数据分布、一致性、扩展性等复杂设计,全部由统一存储层来实现。

此种架构的优势在于:统一的存储底座利于构建多协议统一存储,无中心的元数据架构支持无限扩展能力,多种可选的开源方案易于构建二次开发产品。

但其劣势也比较明显:跨网络的多层服务逻辑转换带来较高的IO延迟,动态数据映射对于集群的硬件稳定性过度依赖,开源软件的功能过度臃肿,各模块代码质量参差不齐,对于产品研发团队的技术能力挑战非常大,自主可控性不足。

青鸾汲取多年类CEPH架构产品研发、运营的经验,取长补短,针对国产芯片平台重新设计,摒弃华而不实的中间架构,从生产实用的角度重新构建,将产品的运维功能与后台功能纳入整体设计,遵循一致的设计理念,化繁为简,深度理解用户需求,突破现有技术制约。

·充分释放国产芯片的多核能力,带来媲美X86的巨大性能突破

·贴近生产业务场景针对性优化,从业务方案加速国产存储替换过程

·突破分布式存储传统能力边界,延伸业务能力

青鸾V2.0在性能上获得突破性提升,其在X86平台上的性能超过目前市场上主流的Ceph架构2倍以上;青鸾V2.0在国产化平台的表现尤为凸显,综合IOPS、吞吐量、延时等数据,其申威平台上的性能表现更是达到了Ceph类存储产品的5-8倍,更高效、稳定的满足用户多样性业务需求。

创新架构,释放产品极致性能

青鸾以分布式文件系统为底座,采用扁平化架构,支持插件化设计,面向未来提供丰富的增值扩展能力,同时隔离物理运行环境,使得与外部平台的融合更加顺畅。

青鸾整体构架图

简单智能的运维体验

青鸾的交互体验设计遵循极简理念,运维人员只需掌握基本的服务器运维知识,无需深入理解青鸾和存储系统,即可做到轻松出色的运维。

青鸾可以提供简单便捷的存储集群部署体验,通过引导式流程,轻松几步完成管理集群部署。而后以“向导+新手”的指引模式,引导用户完成集群的初始安装部署。集群附加插件以简单的“启用插件”流程,引导用户完成譬如对象存储插件、NAS插件的安装,只需用户提供最少的必要信息,以最简流程完成自动的服务部署和启动。高速并行的多节点初始化安装,即使在大规模集群下,也能在短时间内完成环境搭建,过程全自动化,简单快捷。

同时,智能监测集群状态、服务状态、硬件资源利用情况,异常状态告警上报,便于运维人员了解集群真实状态,并根据告警采取相应应对措施。统一的全局故障代码定义,便于多方沟通时的快速问题确认。

多平台异构融合

同一集群支持X86、申威的异构融合管理,可同时部署和管理不同类型主机。弱化主机架构约束,集群各组件可以灵活的分配到异构主机中,对外提供统一的存储视图,统一的命名空间。

各种架构主机可以灵活扩展,没有架构约束,没有比例约束,便于异构集群向同构集群的渐进式演化过程。

数据多协议互通

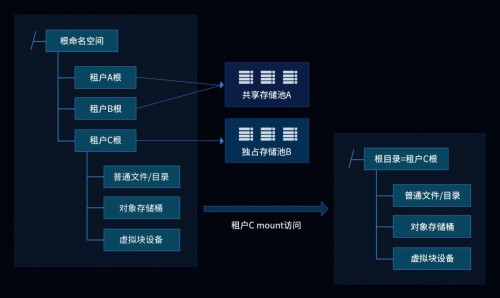

租户的数据能够以多种协议访问,不论是NAS存储、对象存储还是块存储,均共享一份底层数据,且受到一致的数据访问锁控制,在底层真正做到跨协议数据的一致性保护。

架构上采用扁平的数据共享模式,而非协议之间的搭积木式的协议转换数据堆叠模式,各种协议能够得到更一致的性能体验。

高性能IO框架

青鸾采用全旁路技术,针对NVMe SSD支持SPDK用户态IO栈,支持RDMA网络技术,充分释放硬件性能。

统一租户体系

青鸾的一体化设计,租户不区分协议,文件系统、对象存储、NAS、块存储等,全部共用一个租户体系,享有一致性的数据权限。简而言之,租户的账号密码可以用于登录界面访问,可以挂载文件系统,可以访问对象存储。每种访问场景,仅支持访问自己拥有的数据和其它租户授权访问的数据。

插件化架构

青鸾设计上采用插件式架构,基础版本为分布式文件系统。其他所有的附加功能,均以插件的方式进行集成。

基于插件架构的极高灵活性,青鸾与生态产品的融合变得更简单,青鸾也更容易被纳入到既有的IT基础设施体系,灵活的插件选择可以带来不同的产品形态,让不同的用户群体都能得到更好的产品体验,量体裁衣,未来新的功能模块扩展也不会对既有的青鸾平台造成污染,这将为青鸾带来更持久的生命力以及持续的稳定性表现。

性能数据

1、申威6B平台

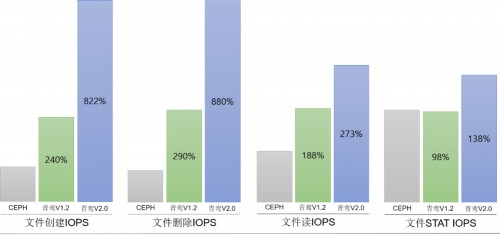

以最具代表性的文件操作性能为例,对比CEPH、青鸾V1.2、青鸾V2.0的性能数据。下述为单台2NVME SSD + 10 HDD的申威6B服务器下的实测数据取整。

可见,在申威6B平台,青鸾2.0的元数据写性能将近CEPH架构的5-8倍,元数据读性能为1.5-3倍,具备巨大的提升。

2、X86平台与申威6B青鸾

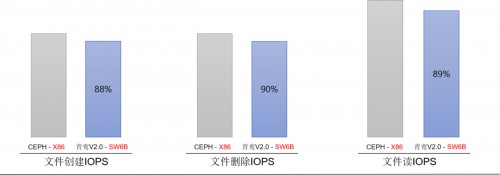

下面的对比将同等配置下,CEPH架构在X86平台(intel 至强 E52620 V4)性能,与青鸾在SW6B平台性能进行对比,有很好的业务实用性意义。

可见,6B上的青鸾元数据写性能为CEPH X86的80%-90%,二者基本一致。可以实现X86替代的使命。

面向丰富应用场景,助力客户核心业务成长

HPC场景/AI场景

青鸾为应对计算集群对文件存储极致的性能要求,采用了自主设计的独立高效的元数据存取访问策略;缩短了IO访问路径,海量文件场景下文件访问性能无衰减,且突破了以往单个命名空间可承载的文件数量限制带来的瓶颈。通过文件系统性能的提升,使计算平台持续处于高效率运转状态,从而缩短平台运转工作时间。

面对AI场景,青鸾为AI业务提供一个横向扩展的底层存储平台,可承载上百亿KB级小文件,为机器学习平台成千上万的客户端提供并发访问支持,满足AI训练中计算集群高带宽、低延时的访问需求,使计算资源得到最大化利用,且在数十亿文件数量下仍然能够提供稳定的数据访问性能,有效提升训练效率。

海量非结构化数据

基于分布式文件存储,提供底层扁平化的存储管理服务;基于上层内容管理平台,以标准RESTful接口提供高效的影像文件处理服务。

大数据应用,平台国产化对接申威

基于自研SDK替代HDFS文件系统,解决大数据在扩展性、小文件存储、元数据管理等方面的瓶颈,为Hadoop、Spark提供存储服务,同时实现国产化对接基于申威的大数据平台。

云平台对接

青鸾在分布式文件存储的基础之上,提供各种协议,支持CSI,为OpenStack、K8S等虚拟化及容器云平台提供存储服务。

同时,青鸾为用户提供标准CSI插件无缝对接Kurbernetes,简化使用流程,提升可用性和数据访问性能,并以此提供众多企业级功能,如支撑容器化AI训练平台,满足业务使用、管理运维等方面需求。

传统NAS替代

以分布式存储架构,提供标准NFS/CIFS/FTP/POSIX服务,替代传统NAS,突破性能、容量瓶颈。

产品的研发从来不是一蹴而就的,元核云会继续加大产品研发投入,深化分布式存储技术的创新,增强产品功能,提升产品性能,并且采用多种冗余策略强化产品安全性能,保障客户业务底层的安全稳定。

另一方面,青鸾将深化业务场景的探索,结合具体的场景需求做进一步的针对性调整与优化:针对高性能应用场景,升级全闪存储阵列;针对国产化应用场景,逐步支持对多种国产芯片的适配。并且,青鸾将首先实现于军工、政务等领域的规模化应用,赋能行业客户完成全国产化替代,实现自主可控的总体目标。

未来,元核云将紧随国家信息化建设总趋势、总方针的引导,持续发力,坚定不移走自主可控的国产化道路,秉承独立自主的创新精神,坚守自主研发的初心,打造新一代国产化分布式存储,为自主可控长远发展提供最坚实的数据底座!