Qzone

Qzone

微博

微博

微信

微信

日前,阿里云通义千问方面宣布开源大模型Qwen1.5-110B,其中包括Qwen1.5-110B-Base和Qwen1.5-110B-Chat两个版本。据悉,这也是目前Qwen1.5系列中首个拥有超过1000亿参数、规模最大的模型,以及目前国内参数规模最大的开源模型。

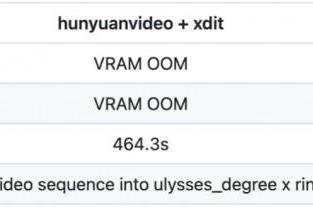

据了解,Qwen1.5-110B与其他Qwen1.5模型相似,采用了相同的Transformer解码器架构,并包含分组查询注意力(GQA),在模型推理时更加高效。此外,该模型支持32K tokens的上下文长度,并同样支持多种语言,包括英、中、法、西等。按照1100亿参数估计,Qwen1.5-110B模型半精度的推理显存需要220GB。

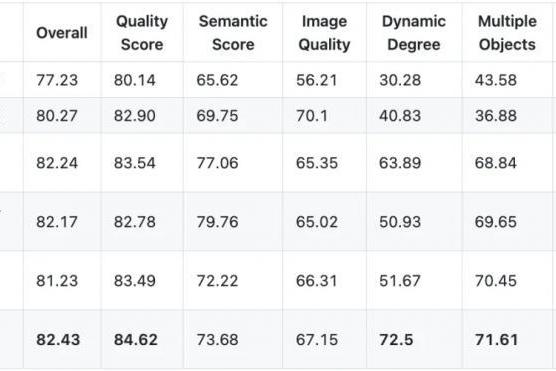

据通义千问方面透露,该模型在基础能力评估中已与最近发布的SOTA模型Meta-Llama3-70B以及Mixtral-8x22B相媲美,并在Chat评估中表现出色,包括MT-Bench和AlpacaEval 2.0。具体而言,在综合理解测评MMLU、数学推理测评GSM8K和MATH等测评中,Qwen1.5-110B的得分略高于Meta-Llama3-70B、Mixtral-8x22B,在编程测试HumanEval中,Qwen1.5-110B的得分远高于Meta-Llama3-70B、Mixtral-8x22B。

据了解,通义千问方面还透露,并没有对Qwen1.5-110B的预训练方法进行大幅改变,因此该模型和Qwen1.5-72B相比的性能提升主要来自于增加模型规模。对此通义千问方面表示,“未来团队将会探索模型规模提升和扩展预训练数据规模两种方法同时带来的优势”。

值得一提的是,至此阿里云通义千问方面已相继开源包括5亿、18亿、40亿、70亿、140亿、320亿、720亿、1100亿参数规模在内的8款大模型。

此前阿里云CTO周靖人曾指出,“开源生态对促进中国大模型的技术进步与应用落地至关重要,通义千问将持续投入开源,希望成为‘AI时代最开放的大模型’,与伙伴们共同促进大模型生态建设”。

【以上内容转自“三易生活网”,不代表本网站观点。如需转载请取得三易生活网许可,如有侵权请联系删除。】

延伸阅读: