Qzone

Qzone

微博

微博

微信

微信

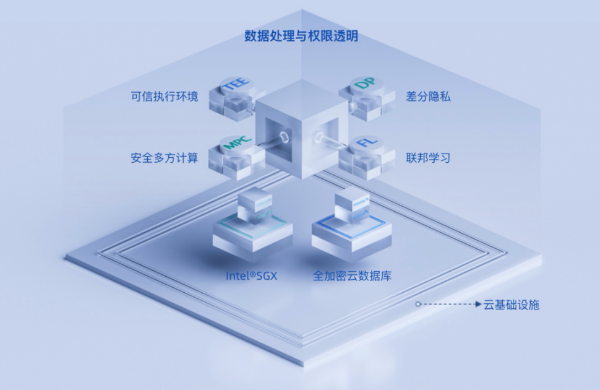

导语:DataTrust(隐私增强计算产品)是基于阿里云底层多项基础安全能力,经过阿里云数据中台丰富的客户业务实践,构建的一款为企业数据安全流通的产品。

随着包括零售、制造、金融等多行业数字化转型加速推进,数据的价值正在被越来越多的企业广泛认知,国家亦出台多项政策,明确数据要素的基础性、战略性地位,要求加强数据资源整合、应用于安全管理,提升数据资源价值。

同时,面对持续扩大的安全威胁维度和行业监管要求,企业对数据安全的防护力度要求也在不断加码,亟需一套完整的数据安全产品,实现不同场景应对的数据安全保护。

响应国家及市场要求,近日,阿里云数据中台产品矩阵之一的隐私增强计算产品DataTrust正式对外发布。

记者了解到,DataTrust依托阿里云底层多项基础安全能力,及阿里云数据中台丰富的应用场景实践,能够在保障数据安全的前提下完成多方数据联合分析、联合训练、联合预测,实现数据价值的流通,为企业提供立足数据业务原生的数据安全流通解决方案。

可用不可见保障数据多方计算安全

营销投放是零售企业最常面对的商业场景之一。

零售企业选择一个媒介渠道进行营销投放时,为了保证相对最优投放效果,往往需要提供自身已覆盖市场数据与渠道数据交叉计算分析,并进行模型训练和预测,以确保此次营销投放的确能够触达目标市场。

但在这个过程中,企业往往又不希望自身市场数据被媒介渠道获悉,因此在数据处理过程中,需要有个“安全环境”,做到在数据不流通的前提下实现数据价值的流通,达到包括数据分析、匹配、分层等动作都局限在“安全环境”范围内产生,待数据处理完成后,直接产生数据结果,以方便后续基于业务场景的直接使用。

“安全环境”的作用就在于,能够让企业和平台都在无法获悉对方基础数据的前提下,完成数据业务分析及数据应用,做到数据的可用不可见。

而DataTrust就充当了黑匣子角色,基于业内领先的隐私增强技术,它能够为数据参与多方构建一个统一的数据安全融通环境,实现ID去标识化、特征标签保护、商业数据保护等多方面目的——此外,DataTrust通过一体化的使用交互和体验,大大降低了企业使用门槛,同时数据处理动作和流程能够被清晰表达。

目前,DataTrust产品能力已通过阿里云数据中台在多个行业获得实践,尤其是在“智能营销”“智能广告推荐”等场景,获得企业极大认可。

多维核心技术数据安全背后的多重把关

为什么DataTrust一经推出就能经受多行业不同数据安全场景挑战?除了依靠阿里云数据中台在零售、金融、互联网等多个细分行业解决方案的切入外,更重要的一点还在于,其内嵌的四大核心技术,可针对不同行业数据安全标准及企业个性化数据隐私需求,给予特定匹配。

比如,零售企业在数据安全层面核心保障数据合规使用及防泄漏(隐私保护),需要充分遵守包括《网络安全法》《电商法》《消费者保护法》等法律法规的要求;但在金融或者医疗行业,有更高的基于行业的数据安全保障标准,因此在这些行业,在数据安全技术上也必须提出更高要求。

据介绍,DataTrust现阶段已拥有四大隐私增强计算核心技术。

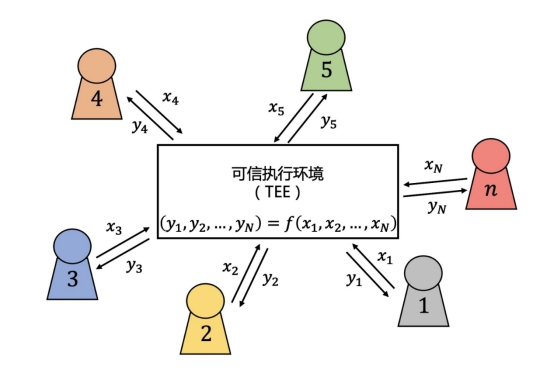

一、可信执行环境(Trusted Execution Environment,TEE)

TEE是硬件中的一个独立的安全环境中,与操作系统并行运行。硬件本身保证TEE中代码和数据的机密性和完整性,也就是说,TEE是硬件服务提供商应用硬件在现实世界中构造的安全计算环境。

应用TEE实现隐私增强计算的过程可以通过下图描述。

·步骤1:各个参与方将自己的数据x通过安全链路传输给TEE;

·步骤2:TEE在保证机密性和完整性的条件下完成计算任务;

·步骤3:TEE通过安全链路将计算结果发送给各个参与方。

目前,DataTrust应用英特尔的软件防护扩展(Software Guard Extensions,SGX)作为TEE。

SGX是Intel CPU提供的一组指令集和内存访问机制,应用程序可以通过这组指令集和内存访问机制实现一个被称为安全区(Enclave)的容器,在应用程序的地址空间中划分出一个被保护的区域,为容器内的代码和数据提供机密性和完整性保护,免受拥有特殊权限的恶意软件的破坏。

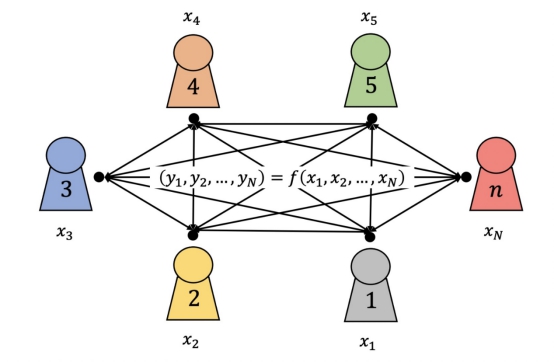

二、安全多方计算(Secure Multi-Party Computation,MPC)

MPC是密码学中的定义,意为在无可信计算方的情况下,多个参与方各自持有秘密输入完成对某个函数的计算,但每个参与方最终只能得到计算结果和能从自己输入和计算结果中推出的信息,其他信息均可得到保护。

安全多方计算的定义可以通过下图描述。

DataTrust目前支持专用MPC协议隐私集合求交(Private Set Intersection,PSI)实现两方数据的安全匹配;同时,支持上亿级别输入的PSI协议,并根据单次匹配、周期性匹配、增量匹配等实际业务场景提供不同类型PSI协议的支持。

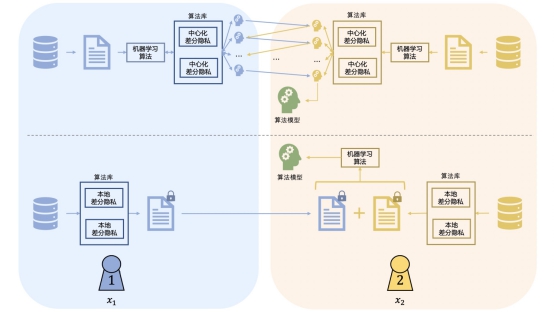

三、联邦学习(Federated Learning,FL)

联邦学习是一种多个参与方在保证各自原始私有数据不出数据方定义的私有边界的前提下,协作完成某项机器学习任务的机器学习模式。

根据隐私安全诉求与训练效率的不同,可以通过MPC、同态加密(Homomorphic Encryption,HE)、差分隐私(定义见下)等多种方式实现联邦学习。

DataTrust支持基于差分隐私的联邦学习,相应技术方案在保证效果和性能的前提下,拥有安全上的理论支撑。值得注意的是,DataTrust支持的联邦学习算法已覆盖神经网络和决策树等常用算法。

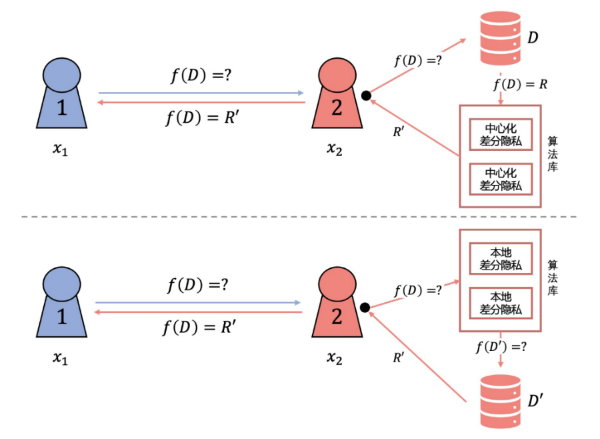

四、差分隐私(Differential Privacy,DP)

DP是一种基于对数据引入随机扰动,并从理论层面度量随机扰动所带来的隐私保护程度的隐私保护方法。根据随机扰动方式的不同,DP分为在原始数据层面进行随机扰动的本地差分隐私(Local Differential Privacy,LDP)和在计算结果层面进行随机扰动的中心差分隐私(Central Differential Privacy,CDP)。

DataTrust在FL层面应用DP实现训练/预测过程中的个人隐私保护,并综合使用CDP/LDP技术,以支持不同的学习/预测任务。

需要注意的是,DataTrust的多套核心技术并非一成不变,而是能够依据企业日益丰富的数据安全场景,进行升级更迭,同时还将继续引入更多行业领先的隐私增强计算技术,充盈产品底层能力,“持续响应政策数据监管要求,顺应市场数据安全诉求,将保障数据安全的能力全量开放给有需要的企业,将会是DataTrust未来相当长时间内的战略目标。”DataTrust产品负责人如是说。